Что означает энтропия простыми словами?

В современном мире статистическая наука является неотъемлемой частью в жизни каждого общества. Она дает возможность определить динамику развития любого явления или процесса. Одной из вероятностных статистических величин, с помощью которой можно объяснить практически все процессы человеческой жизнедеятельности как социальные, так и индвидуальные, является энтропия. Что же означает простыми словами этот многогранный термин?

Содержание:

Определение

Энтропия (в переводе с древнегреческого – поворот, превращение) – это мера, степень неупорядоченности (хаоса) какой-либо системы. Используется в следующих точных и естественных науках:

- В математике означает поиск логарифма числа доступных состояний системы;

- В статистической науке – вероятностная величина наступления любого макроскопического состояния системы;

- В термодинамике (физика) – степень необратимой диффузии энергии, т.е. стандартная величина ее потерь, которые неизбежны при взаимодействии более горячего тела с более холодным;

- В информатике – означает информационную емкость системы. Интересным фактом является следующее: Клод Шеннон (основоположник этого термина в информационной теории) первоначально думал назвать энтропию информацией.

История возникновения

Впервые понятие энтропии было введено в эпоху развития термодинамики, когда возникла необходимость в изучении процессов, происходящих внутри термодинамических тел. В 1865 году ученый-физик из Германии Рудольф Клаузиус этим термином описал состояние системы, в котором теплота имеет способность преобразовываться в иные виды энергии (механическую, химическую, световую и т.д.).

Прирост энтропии вызван притоком тепловой энергии в систему и связан с температурой, при которой этот приток возникает. Необходимость этой величины была вызвана тем, что вся физика строится на идеализации абстрактных объектов (идеальный маятник, равномерное движение, масса и т.д.).

В бытовом понимании энтропия представляет собой степень хаотичности и неопределенности системы: чем больше в системе упорядоченности, и чем больше ее элементы подчинены какому-либо порядку, тем меньше энтропия.

Пример: Шкаф – это определенная система. Если в нем все вещи лежат на своих местах, то энтропия меньше. Если же все вещи разбросаны и лежат не на своих полках, то соответственно она становится больше.

С этим термином тесно связана тепловая функция энтальпии – характеризует состояние термодинамической системы в состоянии равновесия при выборе ряда независимых переменных, таких как давление, энтропия и число частиц.

Величина, противоположная энтропии, называется экстропией.

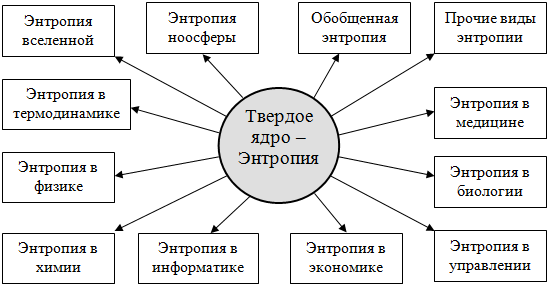

Виды энтропии

Области применения:

- физическая химия;

- экономические науки;

- статистическая физика или информационная теория;

- социологическая наука.

Рассмотрим подробнее виды энтропии в каждой из областей ее применения.

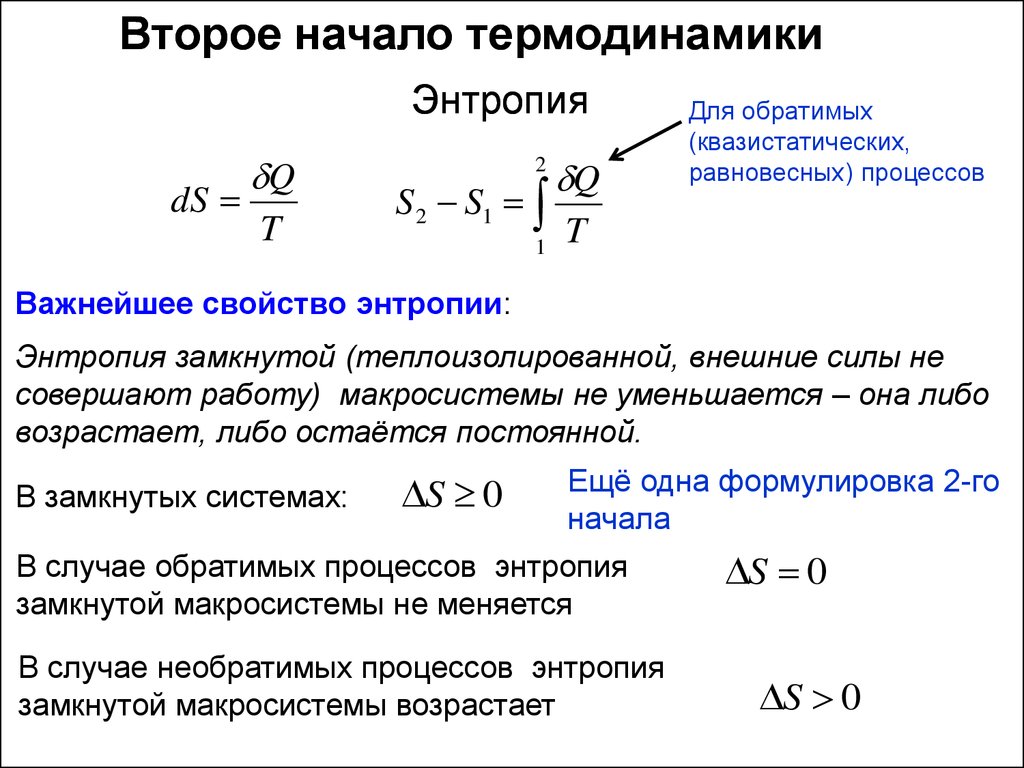

В термодинамике

В термодинамике (физической химии) энтропия – это та степень, в которой реальный процесс отклоняется от идеального. Основной постулат термодинамики, сформулированный физиками на базе изучения энтропии: каждая система термодинамики, которая изолирована от внешнего мира, постепенно становится равновесной и впоследствии не имеет возможности выйти самостоятельно из состояния равновесия. Беспорядок – основная характеристика состояния любой системы. Из него она стремится к равновесию.

Возникает вопрос: с помощью чего определить степень беспорядка?

Основной метод: каждому возможному состоянию системы присваивается число вариантных комбинаций, которыми это состояние может быть реализовано.

Вывод: чем больше число вариантов, тем больше величина энтропии. Чем больше организованности в структуре вещества, тем меньше его неупорядоченность.

Абсолютная величина энтропии равна приращению имеющейся в системе тепловой энергии в условиях теплопередачи при заданной температуре.

Клазиус определял энтропию как совокупность приведенных тепловых энергий, как функцию состояния системы, которое остается неизменным в условиях замкнутости, а в условиях открытых необратимых процессов – оно всегда положительно изменяется. Ее значение отражает связь между макро- и микросостояниями. Это единственная функциональная величина, показывающая направленность процессов. Но она не показывает сам процесс перехода состояний из одного в другое, а находится лишь исходным и итоговым состоянием системы.

В экономике

Коэффициент энтропии дает возможность проанализировать уровень концентрации рынка и его изменение. Чем этот коэффициент ниже, тем меньше неопределенность внешней среды, что ведет к повышению вероятности возникновения монополий. Этот показатель выступает в качестве косвенного помощника в оценивании выигрыша, который получает предприятие в ходе ведения монополистической деятельности или в условиях изменения рыночной концентрации (влияет на число потенциальных конкурентов фирмы).

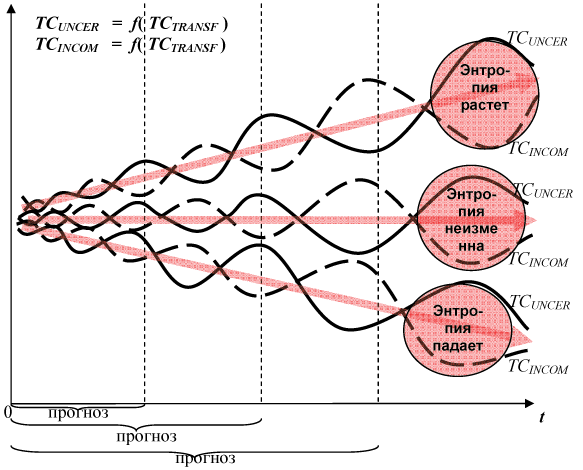

В информатике или статистической физике

Информационная энтропия – это степень непредсказуемости информационной системы. Этот показатель служит для определения степени хаотичности эксперимента, который проводится или произошедшего события. Значение хаотичности прямопропорционально числу состояний, нахождение системы в которых возможно. Все действия, направленные на упорядочивание системы, ведут к появлению информационных сведений о ней и снижают информационную неопределенность, которая выявляет пропускную способность информационного канала, обеспечивающую надежность и достоверность передачи информационных данных. Это позволяет прогнозировать частично возможный ход эксперимента, т.е. предсказывать вероятность того или иного события.

Пример: расшифровка закодированного текста. Для этого анализируется вероятность возникновения того или иного символа и высчитывается величина их энтропии.

В социологии

Энтропия – показатель, характеризующий отклонение общественной системы или ее составных частей от заданного (образцового) состояния. Проявления этого отклонения:

- уменьшение эффективности общественного развития и жизнедеятельности общества как целостной системы;

- снижение способности к самоорганизации.

Пример: персонал организации настолько загружен бумажной работой (составлением отчетов, ведением документации), что не может успевать выполнять свои должностные функции и обязанности (осуществление аудита). Мера неэффективного использования трудовых ресурсов собственником предприятия – это информационная неопределенность.

Примеры

Из бытовой жизни:

- При написании sms-сообщений на мобильном телефоне мы часто пользуемся программой Т9. Чем меньше ошибок в печатаемом нами слове, тем процесс его распознания программой будет легче и она быстрее предложит нам его замену. Вывод: чем больше беспорядка, тем больше информационная неопределенность.

- Когда мы бросаем два кубика при игре в кости, существует только один способ выкинуть комбинацию 2 или 12 (1 и 1, 6 и 6). Самое максимальное число способов выкинуть число 7 (6 вероятных комбинаций). Непредсказуемость в данном случае будет максимальной.

- Информация о количестве учеников больше в течение урока, чем во время перемены. Поскольку на уроке каждый ученик сидит на своем месте, то энтропия ниже. За пределами класса для передвижения школьников характерна хаотичность, что ведет к увеличению значения энтропии.

- Если прибрать на рабочей парте, разложить предметы по своим местам, то можно больше получить информации о том или ином предмете, находящемся на ней. Упорядоченность вещей на парте снижает величину энтропии.